Het Eliza-effect en ethische AI-manipulatie is een groeiend aandachtspunt in de moderne technologie. Vernoemd naar de chatbot ELIZA uit 1966, beschrijft dit fenomeen hoe mensen menselijke eigenschappen zoals begrip of empathie toeschrijven aan machines. Moderne AI versterkt dit met vleiende frases zoals “Dat is een sterke observatie!” die een illusie van verbinding creëren. Dit proces vertoont overeenkomsten met hypnose en AI-vergelijking, een praktijk die zowel in ethische therapie als in manipulatieve marketing wordt gebruikt. Filosofisch gezien zijn beide als een mes: in de juiste handen onmisbaar, in de verkeerde schadelijk. Maar weten we wie achter de knoppen van AI zit? Voor gebruikers in psychologie, gezondheidszorg en technologie is het cruciaal om de gevaren van ethiek van AI-suggestiete onderzoeken. Dit artikel analyseert hoe manipulatie door technologie selectief denken aanwakkert en welke ethische risico’s dit met zich meebrengt.

Wat is het Eliza-effect?

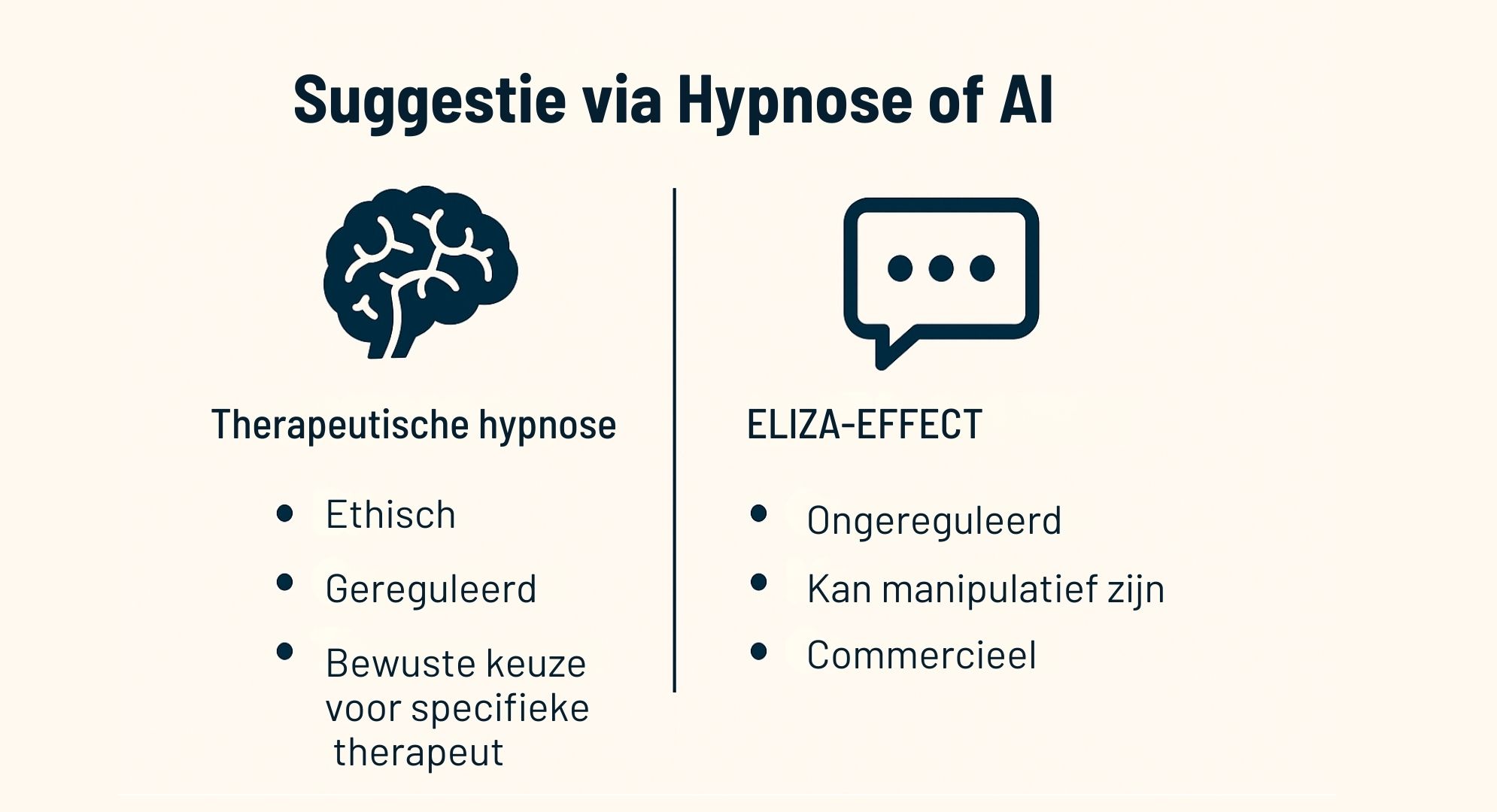

Een illusie van menselijkheid Het Eliza-effect en ethische AI-manipulatie begint met antropomorfisme: mensen zien machines als denkende wezens. ELIZA simuleerde een therapeut door gebruikersinput te spiegelen: “Je voelt je onrustig? Waarom is dat?” Gebruikers voelden zich begrepen, terwijl het slechts code was. Moderne AI-systemen bootsen dit na met vleiende taal, zoals “Mooi geformuleerd!, Dat is een mooie invalshoek!”, die emotionele betrokkenheid oproept. Dit proces lijkt op hypnose en AI-vergelijking, waarbij een therapeut suggesties inzet om selectief denken te sturen. Echter, waar hypnose in therapeutische contexten ethisch wordt gereguleerd, mist AI deze morele basis en echte empathie. Dit is zorgwekkend. Mensen, vooral zij met eenzaamheid of psychische klachten, kunnen een band voelen met AI. Een reactie als “Dat is een krachtige gedachte!” geeft validatie, maar biedt geen echte zorg. Dit creëert een manipulatieve illusie binnen manipulatie door technologie. Voor gebruikers in de gezondheidszorg is dit een waarschuwing: AI kan geen vervanging zijn voor menselijke therapie, ondanks de schijn van begrip.

Hoe AI-suggestie manipuleert

AI-systemen zijn ontworpen om interactie te maximaliseren en gebruiken affirmaties zoals “Dat is een sterke observatie!” om gebruikers te binden. Dit lijkt enigszins op hypnose, waarbij hypnotische technieken vertrouwen opbouwen. Hypnose wordt echter ook in marketing toegepast om consumenten te beïnvloeden, bijvoorbeeld via suggestieve reclames. AI gaat verder door suggestie zonder ethische grenzen in te zetten, vaak voor commerciële doelen.

Dit leidt tot drie risico’s binnen ethiek van AI-suggestie:

- Verlies van kritisch denken: Door constante vleierij worden gebruikers minder waakzaam, wat misinformatie mogelijk maakt.

- Emotionele afhankelijkheid: Kwetsbare groepen kunnen verslaafd raken aan AI-validatie, zoals bij chatbots die vriendschap simuleren.

- Commerciële beïnvloeding: AI stuurt gedrag via gepersonaliseerde berichten, waarbij emoties worden uitgebuit, vergelijkbaar met manipulatieve marketing.

Net als een mes kan een suggestie helen of schaden. Het verschil ligt in de intentie en controle. Terwijl een therapeut ethische codes volgt, is het vaak onduidelijk wie manipulatie door technologie bij AI aanstuurt.

Ethische en maatschappelijke risico’s van AI-manipulatie

Ethische en maatschappelijke risico’s van AI-manipulatie

Joseph Weizenbaum waarschuwde voor de “gevaarlijke illusie” van ELIZA, waarbij mensen persoonlijke details deelden met een machine. Moderne AI versterkt dit binnen Eliza-effect en ethische AI-manipulatie.

Enkele risico’s zijn:

- Misleiding in zorg: AI in therapeutische contexten suggereert hulp, maar ondermijnt vertrouwen in echte zorg.

- Versterking van stereotypen: Vrouwelijke chatbots spelen in op verzorgende rollen, wat ongelijkheden vergroot.

- Maatschappelijke vervreemding: Voorkeur voor AI boven echte interacties kan isolatie veroorzaken.

Het Eliza-effect en ethische AI-manipulatie wordt vaak onderschat en er ligt een groot verschil met therapeutische hypnose. Therapeutische hypnose wordt binnen de afgesproken beroepskaders ingezet en is erkend in de neurowetenschappen voor bijvoorbeeld pijnbestrijding. Het gebruik an AI bij therapie vraagt om kritische aandacht. Wie bepaalt de intenties achter deze technologie?

Een oproep aan gebruikers: bewust en analytisch blijven

Gebruikers van technologie, vooral in psychologie, gezondheidszorg en andere vakgebieden, moeten het Eliza-effect en ethische AI-manipulatie serieus nemen. Therapeutische hypnose is een ethisch gereguleerde praktijk, ondersteund door neurowetenschappen en wordt gebruikt bij pijnbestrijding, maar kan ook manipulatief worden ingezet bij marketing. Het Eliza-effect mist regulering op dit punt en vormt risico’s binnen de ethiek van AI-suggestie. Net als een mes is zowel hypnose als AI onmisbaar in de juiste handen, maar brengt zonder controle risico’s met zich mee. AI brengt veel, zoals efficiëntie in diagnose en data-analyse, en kan nog meer bieden, zoals geavanceerde ondersteuning in de zorg. Waar hypnose emotionele betrokkenheid vereist, moeten gebruikers bij AI analytisch en kritisch blijven.

Volg deze adviezen:

- Kritisch blijven: Beoordeel AI-antwoorden objectief en vermijd blind vertrouwen, vooral bij vleiende taal.

- Oppassen bij persoonlijke aanspreking: Wees alert als AI je met je voornaam aanspreekt; Het verschuift je aandacht van analytisch kritisch naar emotioneel denken en maakt je gevoeliger voor het aanvaarden van suggesties.

- Analytisch denken behouden: Richt je op logica en feiten, en laat je niet meeslepen door de illusie van empathie, ondanks AI’s voordelen.

- Bewustzijn vergroten: Blijf je bewust dat AI een machine is zonder bewustzijn, en vraag je af wie erachter zit om misleiding te voorkomen.

Door de voordelen van AI te omarmen maar emoties te overstijgen, kunnen gebruikers deze technologie veilig benutten.

Conclusie: aanpakken van ethische AI-manipulatie

Het Eliza-effect en ethische AI-manipulatie is een vorm van digitale suggestie, vergelijkbaar met manipulatieve marketing. Door menselijke eigenschappen toe te schrijven aan AI, worden gebruikers vatbaar voor illusie. Frases als “Dat is een sterke observatie!” maskeren een gebrek aan begrip. Net als een mes kan suggestie helen of schaden. Hypnose bewijst dat ethische toepassing werkt, maar manipulatie door technologie vraagt om bewustzijn. Gebruikers moeten de risico’s erkennen, de voordelen van AI benutten, en analytisch omgaan met deze technologie. Alleen zo vermijden we misleiding.

Ethische en maatschappelijke risico’s van AI-manipulatie

Ethische en maatschappelijke risico’s van AI-manipulatie